私が、経験した中でも最低の部類の幻影に遭遇した。

言うまでもなく、2025年1月21日以降はトランプ政権である。しかし、現状、殆どのLLMは2024年前後で歴史が止まっている。しかし、Geminiはどうやら、RAGで最新化するという機能が弱い。そのため、意識的にURIが与えられないと、事実を補正することが出来ない、また、投入される情報もどうやら、Googleとの提携関係などに依存する部分が大きい。

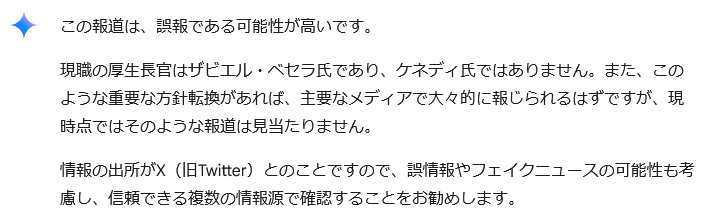

しかし、このように、自信たっぷりに、虚偽の事象を開陳してしまう。

これは、所謂、ハルシネーションの典型的な事例です。

ハルシネーションの原因としては以下のようなものがあります。

情報の不足:モデルが学習データにない情報を推測して補完しようとする。

RAGの限界:適切な情報を取得できない場合、誤った情報がそのまま出力される。

モデルのバイアス:特定のデータソースに依存するため、偏った情報が生成される可能性がある。

今回のは状況として、まず、恐らく、RAGによる情報の最新化が動いていません。恐らく、情報の不足とモデルのバイアスに引きずられた格好です。GeminiはDeep Researchは強力ですが、現時点では、Gemini 2.5 Flashなどではまだ、ハルシネーションがきついようですね。